文章信息

基金项目

- 广东省农业科学院农业优势产业学科团队建设项目(202125TD);广东省现代农业产业技术体系创新团队项目(2021KJ120);广东高校省级重点平台和重大科研项目(2018GkQNCX022);揭阳市科技创新发展专项(210531154613146)

作者简介

- 俞龙(1975—), 男, 博士, 副教授, 研究方向为物联网在农业中的应用相关技术, E-mail: yulong@scau.edu.cn.

通讯作者

- 唐劲驰(1973—), 女, 博士, 研究员, 研究方向为茶树栽培及营养生理, E-mail: tangjinchi@126.com.

文章历史

- 收稿日期:2022-04-04

2. 国家精准农业航空施药技术国际联合研究中心,广东 广州 510642;

3. 广东省农业科学院茶叶研究所/广东省茶树资源创新利用重点实验室,广东 广州 510640;

4. 华南农业大学工程学院,广东 广州 510642

2. National Center for International Collaboration Research on Precision Agricultural Aviation Pesticides Spraying Technology, Guangzhou 510642, China;

3. Tea Research Institute, Guangdong Academy of Agricultural Sciences/Key Laboratory for Innovative Utilization of Tea Tree Resources of Guangdong, Guangzhou 510640, China;

4. College of Engineering, South China Agricultural University, Guangzhou 510642, China

【研究意义】长期以来,中国茶产量和贸易量稳居世界前列,对世界茶产业发展产生了重要影响[1]。进入21世纪以来,农业劳动力不断向其他产业转移,结构性短缺和老龄化趋势成为全球性问题[2]。随着人们对茶叶的需求量越来越大,茶农也需要加速茶叶制作生产的过程,而尤为迫切的是提高茶叶嫩芽采摘效率。现阶段茶叶的采收方式主要以人工手采为主,机械化粗采为辅[3]。机械化粗采虽然解决了人工采摘耗费人力巨大且效率低下的问题,但不能精确区分嫩芽与老叶。

【前人研究进展】机器视觉技术是近20年发展起来的一种新兴检测技术,在农产品的大小分级、形态检测、颜色识别等方面应用较多[4]。针对茶叶嫩芽识别问题,国内外学者基于传统机器视觉开展了许多研究。陈妙婷[5]基于改进PSO-SVM算法对茶叶嫩芽图像进行分割以获取嫩芽特征信息,并选择YOLO算法进行嫩芽采摘点的识别,准确率达到84%以上;唐仙等[6]对RGB颜色模型的色差法(R-B)进行分析,对比研究了多种阈值分割法的优劣;段勇强等[7]基于改进Kmeans算法对富硒绿茶图像进行采集并识别其中的嫩芽,识别率最高达到95%,但该方法在图片分辨率很高的情况下会严重影响聚类过程,存在一定的局限性;周颖颖等[8]基于传统视觉技术对茶叶嫩芽图像进行分割后,再通过对分割后图像的关键区域进行色差判断实现了龙井茶嫩芽的分级并提供了合理的采摘点。上述传统机器视觉的方法虽然能较为准确地识别茶叶嫩芽,但识别的图片背景环境比较单一,对于复杂环境下的识别任务鲁棒性较低,并且在选择物体特征时需要人工进行选择,难以满足更多的实际需求。在提取物体特征方面,基于深度网络的目标检测算法远超于传统机器视觉方法。近年来,越来越多的学者将目标检测算法应用于农业检测领域,代表算法有R-CNN[9]、Fast R-CNN[10]、Faster R-CNN[11]、YOLO(You Only Look Once)[12]及SSD(Single Shot MultiBox Detector)[13]等,它们在农业检测领域不断被改进优化[14],加速了农业作物检测领域的发展。黄河清等[15-16]基于Fcos[17]的思想,以Darknet19为主干网络,连接特征金字塔进行特征多尺度融合,训练完成后,将权重小于30%的通道删除,实现了对柑橘的识别。在茶叶嫩芽识别领域中,张晴晴等[18]针对复杂场景下传统嫩芽识别方法准确率低的问题,提出一种基于改进YOLOV3模型的识别方法,提高模型对茶树嫩芽的识别能力,但在茶树冠层出现与嫩芽相似的其他作物或杂草时,模型可能会出现误检。孙肖肖等[19]将深度学习与OSTU算法结合,对茶叶嫩芽图像进行分割,使得茶叶嫩芽区域更加明显,提高了检测精度,但由于其茶叶嫩芽数据集中小目标较少,会导致模型对目标较小的茶叶嫩芽的检测能力不强,在实际场景中应用时,对于较小的茶叶嫩芽,会出现漏检的情况。许高建等[20]选用基于不同特征提取网络的Faster R-CNN网络模型对茶叶嫩芽数据样本进行训练,得出基于VGG-16网络的Faster R-CNN模型识别效果较好的结论。施莹莹等[21]基于YOLOv3算法,通过单一的特征提取网络进行多尺度目标检测,对自然环境下的茶叶嫩芽进行识别时具有较高的召回率以及准确度。王子钰等[22]通过提取超绿因子对嫩芽图像进行预处理,利用SSD模型进行训练,实现对茶叶嫩芽的检测,但其并未就SSD模型对小目标检测效果不好的问题进行优化。

【本研究切入点】目前,深度学习、神经网络等技术手段发展迅速且日益成熟[23]。YOLO系列算法为“one stage”目标检测算法,在不损失精度的同时,具有较快的检测速度。为改善上述方案的误检、漏检等问题,本研究以YOLOX[24]模型为基本框架对茶叶嫩芽识别展开研究,在模型中融入SE(Squeeze and excitation)[25]注意力模块,并引入Soft NMS[26]算法替代原模型中传统NMS[27]算法。【拟解决的关键问题】采用基于YOLOX改进模型的茶叶嫩芽识别方法,明显改善复杂场景下的识别能力及小目标嫩芽识别能力。

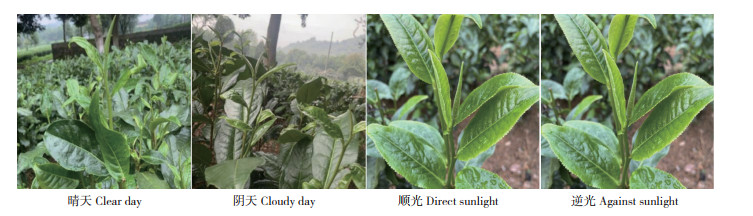

1 数据集准备与模型设计 1.1 数据采集及处理数据集原始图像采集自广东省英德市英德茶叶世界,采集对象为英红九号,采集设备为Iphone XR。对茶叶嫩芽图像进行采集时,嫩芽以外的信息为背景,所拍摄图像包含1个或多个目标。共采集原始图像1 215幅,包括晴天、阴天、顺光、逆光等情况,数据集图片示例见图 1。为加强数据的多样化、提高模型的鲁棒性,对原始数据集进行镜像翻转、光照亮度调整操作。经过镜像翻转后,数据集扩充为2 430幅,再对原始数据集进行亮度调整操作,最终数据集为3 645幅。

|

| 图 1 数据集图片示例 Fig. 1 Sample dataset pictures |

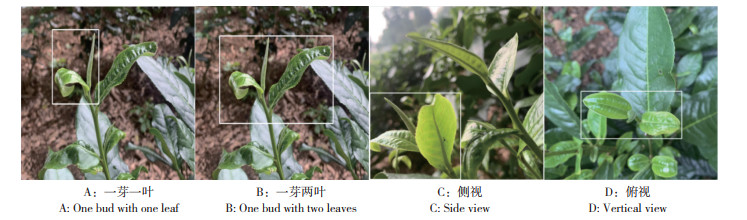

1.2 图像标注

将上述嫩芽图片整理经增强后的数据集共3645张,使用LabelImg图像标注工具对图片中的目标嫩芽进行标注:图 2A表示采集设备正视茶叶嫩芽时一芽一叶的类型,标注为“one”;图 2B表示采集设备正视茶叶嫩芽时一芽两叶的类型,标注为“two”;图 2C表示采集设备侧视茶叶嫩芽的类型,标注为“side”,其特点为嫩叶对嫩芽茎部造成遮挡;图 2D表示采集设备俯视茶叶嫩芽的类型,标注为“top”,其特点为嫩芽本身对茎部造成遮挡。将数据集中晴天、阴天、顺光、逆光4种情况的图片数据均按照70%、20%、10%的比例划分,最终组成训练集2 552幅、验证集729幅、测试集364幅,图片总数3 645幅。

|

| 图 2 茶叶嫩芽标注类型 Fig. 2 Schematic of marking types of tea buds |

1.3 茶叶嫩芽检测模型设计

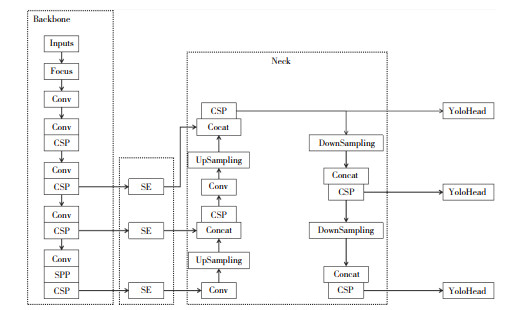

1.3.1 YOLOX模型改进 YOLOX模型主要可分为Backbone、Neck以及YOLO Head 3个部分。输入端的图片首先会在Backbone进行特征提取,提取到的特征信息所包含的位置信息、细节信息较多,语义信息较少;Neck作为YOLOX模型的加强特征提取网络,会结合不同尺度的特征信息,进行上采样特征融合以及下采样特征融合以获取更丰富的特征信息;最后在YOLO Head对获取到的特征信息通过分类器和回归器进行判断,判断是否有对应物体。

由于在Backbone提取的特征包含的细节信息较多,而语义信息较少,小目标(茶叶嫩芽)的特征信息经过处理后,特征信息易丢失,从而引起对茶叶嫩芽的误检和漏检。为提高YOLOX原始模型对小目标嫩芽的检测精度,在原有的网络模型基础上,在Backbone和Neck之间增添SE模块,改进YOLOX网络模型框架如图 3所示。

|

| 图 3 改进YOLOX网络模型框架 Fig. 3 Improved YOLOX network model framework |

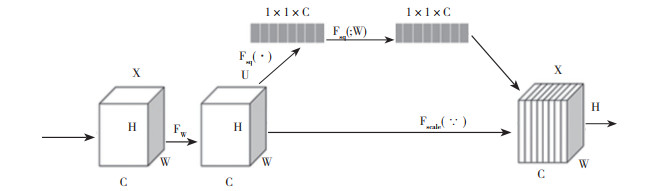

1.3.2 融合SE(Squeeze and excitation)注意力机制 SE模块通过构建特征通道之间的依赖关系,先通过学习的方式获取每个特征通道的重要程度,再依据每个通道的重要程度抑制对识别任务用处不大的特征信息并增强有用的特征信息,提升识别精确度。该模块新增的参数和计算量较小,原模型参数总量为8.94 M,引入SE模块后,模型参数总量为8.99 M。SE模块的结构如图 4所示。

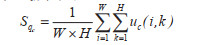

SE模块主要由Squeeze和Excitation两部分组成,Squeeze部分通过全局平均池化操作将原始维度为H*W*C的特征图压缩为1*1*C的特征图,如下式所示:

|

式中,Uc(i, k)表示第i个通道位置为(i, k)的元素,H是高度(height)、W为宽度(width)、C为通道数(channel)。Squeeze操作后获取到H*W的全局特征感受区域更广。

|

| 图 4 SE模块结构 Fig. 4 Structure of SE module |

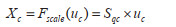

Squeeze操作完成后,通过Excitation操作获得通道之间的依赖关系,这一部分由两个全连接实现,第一个全连接层FC1将C个通道压缩成C/r个通道(r为压缩比例,本研究取r=16),以降低计算量,再经ReLu函数激活通过FC2;第二个全连接恢复回C个通道,再经Sigmoid函数生成权重,最后经过Scale操作生成最终的输出X。

|

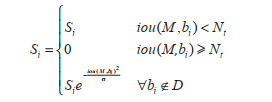

1.3.3 引入Soft NMS算法 目标检测算法在检测过程中,通常会在目标附近产生较多候选框,NMS(Non-Maximum Suppression)算法的核心思想对重叠度较高的候选框进行评分,最后保留分数最高的候选框。利用传统的NMS算法去除检测时的重复框,会将与目标框相邻的且正确识别出物体检测框的分数强制归零,容易导致漏检。针对这种情况,本研究引入Soft NMS算法。Soft NMS算法是基于NMS算法改进而成,为避免出现分数为0的情况,对候选框进行小分数权重打分。权重打分有线性加权和高斯加权两种,本研究采用高斯加权的Soft NMS算法,其计算公式为:

|

式中,Si为当前检测框的得分,M为权重最高的候选框,bi为检测过程中产生的候选框,Nt为IoU阈值,ϭ为高斯惩罚系数,D为最终检测结果集合。两个检测框重叠度越高,高斯惩罚系数越大,则得分Si越小。

1.3.4 试验环境 本试验训练模型使用的操作系统为Ubuntu 20.0.4,处理器为Inter i7 11700@2.6G Hz, GPU型号为Nvidia Geforce RTX3090。测试框架为pytorch1.7.0,使用CUDA 11.0版本并行计算框架配合CUDNN8.0.5版本的深度神经网络加速库。

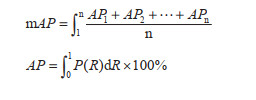

1.4 评价指标本研究所使用模型的性能采用均值平均精度(m AP)进行衡量,计算公式为:

|

|

式中,R为召回率,TP为阳性的正样本数量,FN为阴性的负样本数量,n为目标类别数量。

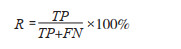

2 结果与分析 2.1 Loss曲线本研究主要参数设置:每次迭代训练的样本数为16,对数据集样本迭代47 000次,初始学习率为0.001,采用余弦退火的学习率下降方式改变学习率,网络模型的Loss值变化曲线如图 5所示。图 5显示了每次迭代的Loss变化,随着迭代次数的增加,模型的损失值减小。在迭代到40 000次左右时,损失曲线趋于收敛,模型可以用于茶叶嫩芽图像的识别。

|

| 图 5 网络模型Loss值变化曲线 Fig. 5 Curve of change in Loss value of network model |

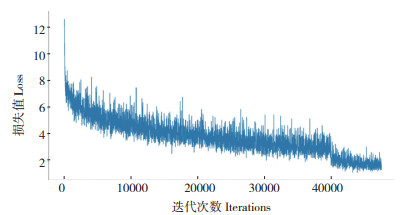

2.2 mAP曲线

本研究检测目标共4类(one、two、side、top),需先计算每一类的平均精度(Average precision, AP),然后再计算所有类的平均精度(mAP)。用相同数据集分别对YOLOX模型和YOLOX改进模型进行训练,在训练结束时,用两个模型得到的最佳权重文件进行性能的对比,改进前后两种模型mAP值变化曲线如图 6所示。从图 6可以看出,随着训练轮数的增加,两种模型的mAP曲线均呈现上升的趋势,且YOLOX模型的收敛速度快于SS-YOLOX模型。在第20个epoch前,YOLOX模型的mAP值略高于SS-YOLOX模型;在第20个epoch后,SS-YOLOX模型的mAP值明显高于YOLOX模型;由图 5可知,在第90个epoch后,SS-YOLOX模型Loss值已不再明显下降,因此在第100个epoch后停止训练。

|

| 图 6 改进前后两种模型mAP值变化曲线 Fig. 6 Curve of change in mAP value of two models beforeand after improvement |

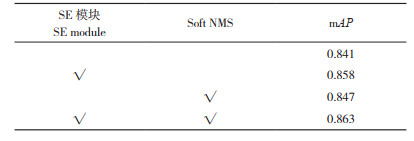

2.3 YOLOX消融

为验证本研究提出的对YOLOX的两种改进策略,对数据集进行消融实验,以判断每个改进点的可行性,在原有模型上加入SE与Soft NMS函数,运用该改进点用“√”表示,训练过程中,除有无运用改进点外,其他参数配置均一致,消融实验结果见表 1。从表 1可以看出,原模型mAP值为0.841,引入SE后,mAP值提高1.7%, Recall提高2%,而引入Soft NMS算法的提升较小。分析认为引入SE后,增强了网络融合特征信息的能力,关注到许多易被忽略的语义信息,因此在检测精度上的提升较为明显;而Soft NMS仅在检测框重叠程度较大时发挥作用,因此仅有小幅度提升。

从实际场景出发,茶叶嫩芽姿态千姿万化,嫩芽大小以及嫩芽数量不同、不同光照的光照条件、采集设备拍摄的距离和角度不同,都会导致由于采集的原始图像的波动对模型识别效果产生影响。下面通过对比两个模型的识别结果,讨论分析两种模型的性能。

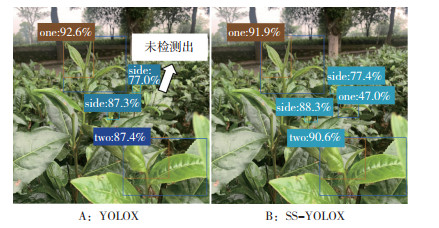

2.4 模型识别结果对比两种模型在茶叶嫩芽数量较多的情况下的识别结果(图 7)显示,两种模型均能识别出茶叶嫩芽,但可以看到YOLOX模型的检测结果(图 7A)有一处一芽一叶“one”类型以及一芽两叶“two”类型没有被YOLOX模型检测到,存在漏检的情况;而SS-YOLOX模型可以检测到(图 7B),表明SS-YOLOX模型对于图片中的小目标检测性能有所提升。

|

| 图 7 两种模型识别结果对比 Fig. 7 Comparison of recognition results of two models |

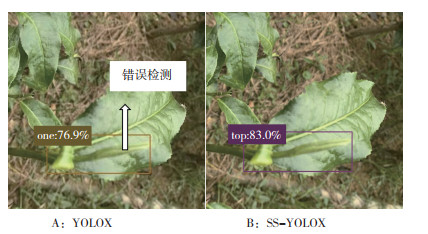

图 8显示,YOLOX原模型存在误检,将“top”类型错误检测为“one”类型,其原因可能是嫩叶遮挡住部分嫩芽,导致模型错误将其检测为“two”类型。

|

| 图 8 错误检测结果 Fig. 8 Error detection results |

3 讨论

YOLOX模型是旷视科技发表的开源高性能检测器,旷视的研究者将目标检测领域中诸如解耦头、数据增强等亮点与YOLOX以往的系列进行集成。本研究基于YOLOX模型,针对在复杂场景下可能出现的茶叶嫩芽误检、漏检的问题,对原YOLOX模型进行改进,引入Soft NMS算法改善检测框重叠时的打分机制。传统的NMS算法在去除与目标框重叠度较高的检测框时,会将相邻的检测框分数强制归零,导致模型容易出现漏检的问题。Soft NMS的打分机制分为两种,分别为线性加权以及高斯加权,本研究采用高斯加权打分机制的Soft NMS算法,两个检测框重叠度越高,惩罚系数越大,得分Si越小,而不是强制归零。此外,在一幅图像中远处的茶叶嫩芽会成为小目标,增大模型的检测难度,容易造成误检、漏检的问题,为了进一步改善以上问题,在已引入Soft NMS算法的模型中融入SE模块,将SE模块加入到主干特征提取网络CSPDarknet和加强特征提取网络FPN之间。SE模块通过学习的方式得到每个特征通道的重要程度,再依据通道的重要程度增强有用的特征信息并抑制无用的特征信息,能够更好地识别图像中的小目标,从而达到提升精度的目的。SE模块内部主要分为Squeeze部分和Excitation部分,引入模块后新增的参数和计算量小,提升精度的同时并不会给网络模型增加繁重的参数量。

由试验结果可知,改进后的模型SS-YOLOX对茶叶嫩芽进行检测,且引入的Soft NMS算法和SE模块均能提升模型的检测性能。虽然本研究模型对茶叶嫩芽图像的识别具有较好的精确度,但未与其他网络模型进行对比,后续将会加入其他检测模型进行研究对比,如Faster R-CNN、SSD模型等。此外,本研究暂未考虑到茶树的叶片对嫩芽遮挡较多的情况,对于遮挡较为严重的嫩芽,在数据集标注阶段根据情况进行了取舍;对于不同茶叶品种对识别结果的影响也暂未作进一步研究。

在后续研究中将会实现软硬件通信,将模型移植入边缘设备,利用边缘设备对茶园中茶叶嫩芽进行实时检测,研究此模型是否能满足实时检测的要求;也会将芽叶遮挡情况对识别结果的影响进行研究,从而提升模型的泛化能力,使其更适用于茶叶嫩芽的识别。

4 结论随着农业工程与信息化技术的迅速发展,农业信息化已经成为一种趋势。针对目前茶叶嫩芽识别领域中的研究现状及出现的问题,本研究提出了一种改进的茶叶嫩芽检测识别模型SS-YOLOX。该模型在原YOLOX模型上融入注意力模块SE,加强模型对特征信息的提取能力,改善小目标的漏检、误检的问题;引入Soft NMS算法改变检测框的打分机制,进一步提高模型的识别准确率。对算法模型进行性能分析,SS-YOLOX的mAP值达到0.863、比原模型提高0.022,召回率为76%、比原模型提高2个百分点,证明了本研究提出模型的可行性。

| [1] |

沈童菲, 王森培, 张慧, 赵颖文. 中国茶产业国际竞争力评价与发展对策[J]. 四川农业科技, 2019(9): 5-11. SHEN T F, WANG P S, ZHANG H, ZHAO Y W. Evaluation and development countermeasures of international competitiveness of China's tea industry[J]. Sichuan Agricultural Science and Technology, 2019(9): 5-11. |

| [2] |

张小花, 马瑞峻, 吴卓葵, 黄泽鸿, 王嘉辉. 基于机器视觉的果园成熟柑橘快速识别及产量预估研究[J]. 广东农业科学, 2019, 46(7): 156-161. DOI:10.16768/j.jssn.1004-874X.2019.07.022 ZHANG X H, MA R J, WU Z K, HUANG Z H, WANG J H. Study on fast recognition and yield estimation of mature citrus in orchard based on machine vision[J]. Guangdong Agricultural Sciences, 2019, 46(7): 156-161. DOI:10.16768/j.jssn.1004-874X.2019.07.022 |

| [3] |

国家统计局. 中华人民共和国2019年国民经济和社会发展统计公报[J]. 中国统计, 2020(3): 8-22. State Statistics Bureau. Statistical Bulletin of the People's Republic of China on National Economi c and Social Development in 2019[J]. China Statistics, 2020(3): 8-22. |

| [4] |

万鹏, 潘海兵, 宗力, 陈红. 基于机器视觉的鲫鱼和鲤鱼品种识别方法研究[J]. 广东农业科学, 2012, 39(17): 184-187. DOI:10.16768/j.issn.1004-874X.2012.17.025 WAN P, PAN H B, ZONG L, CHEN H. Research on variety recognition of Crucian and carp based on machine vision[J]. Guangdong Agricultural Sciences, 2012, 39(17): 184-187. DOI:10.16768/j.issn.1004-874X.2012.17.025 |

| [5] |

陈妙婷. 基于计算机视觉的名优茶嫩芽识别与定位[D]. 青岛: 青岛科技大学, 2019. CHEN M T. Recognition and location of famous tea buds based on computer vision[D]. Qingdao: Qingdao University of Science And Technology, 2019. |

| [6] |

唐仙, 吴雪梅, 张富贵, 顾金梅. 基于阈值分割法的茶叶嫩芽识别研究[J]. 农业装备技术, 2013, 39(6): 10-14. TANG X, WU X M, ZHANG F G, GU J M. Study on tea bud recognition based on threshold segmentation[J]. Agricultural Equipment & Technology, 2013, 39(6): 10-14. |

| [7] |

段勇强, 廖红华, 郑才, 樊珊, 滕召波. 基于改进Kmeans算法的富硒绿茶嫩芽识别[J]. 湖北民族学院学报(自然科学版), 2019, 37(4): 445-448, 462. DOI:10.13501/j.cnki.42-1569/n.2019.12.018 N Y Q, LIAO H H, ZHENG C, FAN S, TENG Z B. Bud recognition of selenium enriched green tea based on improved Kmeans algorithm[J]. Journal of Hubei University for Nationalities(Natural Science Edition), 2019, 37(4): 445-448, 462. DOI:10.13501/j.cnki.42-1569/n.2019.12.018 |

| [8] |

周颖颖, 郑道娟. 使用计算机视觉技术对龙井茶嫩芽识别方法的研究[J]. 福建茶叶, 2016, 38(9): 14-15. ZHOU Y Y, ZHENG D J. Study on the identification method of Longjing tea buds using computer vision technology[J]. Tea of Fujian, 2016, 38(9): 14-15. |

| [9] |

GIRSHICK R, DONAHUE J, DARRELL T, Malik J. Rich feature hierarchies for accurate object detection and semantic segmentation//2014 IEEE Conference on Computer Vision and Pattern Recognition[C]. Columbus, OH, USA: IEEE, 2014: 580-587. DOI: 10.48550/arxiv.1311.2524.

|

| [10] |

GIRSHICK R. Fast R-CNN//2015 IEEE International Conference on Computer Vision(ICCV)[C]. Santiago, Chile: IEEE, 2015: 1440-1448. DOI: 10.1109/ICCV.2015.169.

|

| [11] |

REN S Q, HE K M, GIRSHICK R, SUN J. Faster R-CNN: Towards real-time object detection with region proposal networks//2015 IEEE Conference on Computer Vision and Pattern Recognition[C]. Boston, USA: IEEE, 2015: 91-99. DOI: 10.48550/arXiv.1506.01497.

|

| [12] |

REDMON J, DIVVALA S, GIRSHICK R, FARHADI A. You only look once: Unified, real-time object detection//IEEE Conference on Computer Vision and Pattern Recognition[C]. Las Vegas, USA: IEEE, 2016: 779-788. DOI: 10.1109/CVPR.2016.91.

|

| [13] |

LIU W, ANGUELOV D, ERHAN D, SZEGEDY C, REED S, FU C Y, BERG A C. SSD: Single shot multibox detector//European Conference on Computer Vision[C]. Amesterdam, Holland: ECCV, 2016: 21-37. DOI: 10.1109/ICME.2018.8486464.

|

| [14] |

傅隆生, 宋珍珍, ZHANG XIN, 李瑞, 王东, 崔永杰. 深度学习方法在农业信息中的研究进展与应用现状[J]. 中国农业大学学报, 2020, 25(2): 105-120. DOI:10.11841/j.issn.1007-4333.2020.02.12 FU L S, SONG Z Z, ZHANG X, LI R, WANG D, CUI Y J. Research progress and application status of degree learning method in agricultural information[J]. Journal of China Agricultural University, 2020, 25(2): 105-120. DOI:10.11841/j.issn.1007-4333.2020.02.12 |

| [15] |

黄河清, 胡嘉沛, 李震, 魏志威, 吕石磊. 基于模型剪枝改进FCOS的实时柑橘检测研究[J]. 河南农业大学学报, 2021, 55(3): 453-459. DOI:10.16445/cnki.1000-2340.20210409.002 HUANG H Q, HU J P, LI Z, WEI Z W, LYU S L. Research on realtime citrus detection based on model pruning and improved FCOS[J]. Journal of Henan Agricultural University, 2021, 55(3): 453-459. DOI:10.16445/cnki.1000-2340.20210409.002 |

| [16] |

HUANG H Q, HUANG T B, LI Z, LYU S L, HONG T. Design of citrus fruit detection system based on mobile platform and edge computer device[J]. Sensors, 2022, 22(1): 59. DOI:10.3390/s22010069 |

| [17] |

TIAN Z, SHEN C, CHEN H. Fcos: Fully convolutional one-stage object detection//Proceeding of the IEEE International Conference on Computer Vision[C]. Seoul, South Korea: IEEE, 2019: 9627-9636. DOI: 1048550/arxiv.1904.01355.

|

| [18] |

张晴晴, 刘连忠, 宁井铭, 吴国栋, 江朝辉, 李孟杰, 李栋梁. 基于YOLOV3优化模型的复杂场景下茶树嫩芽识别[J]. 浙江农业学报, 2021, 33(9): 1740-1747. DOI:10.3969/j.issn.1004-1524.2021.09.18 ZHANG Q Q, LIU L Z, NING J M, WU G D, JIANG C H, LI M J, LI D L. Tea bud recognition in complex scenes based on YoloV3 optimization model[J]. Journal of Zhejiang Agriculture, 2021, 33(9): 1740-1747. DOI:10.3969/j.issn.1004-1524.2021.09.18 |

| [19] |

孙肖肖, 牟少敏, 许永玉, 曹旨昊, 苏婷婷. 基于深度学习的复杂背景下茶叶嫩芽检测算法[J]. 河北大学学报(自然科学版), 2019, 39(2): 211-216. DOI:10.3969/j.issn.1000-1565.2019.02.015 SUN X X, MOU S M, XU Y Y, CAO Z H, SU T T. Tea bud detection algorithm under complex background based on deep learning[J]. Journal of Hebei University(Natural Science Edition), 2019, 39(2): 211-216. DOI:10.3969/j.issn.1000-1565.2019.02.015 |

| [20] |

许高建, 张蕴, 赖小燚. 基于Faster R-CNN深度网络的茶叶嫩芽图像识别方法[J]. 光电子·激光, 2020, 31(11): 1131-1139. DOI:10.16136/j.joel.2020.11.0164 XU G J, ZHANG Y, LAI X Y. Tea bud image recognition based on Fasert R-CNN depth network[J]. Photo Electron and Laser, 2020, 31(11): 1131-1139. DOI:10.16136/j.joel.2020.11.0164 |

| [21] |

施莹莹, 李祥瑞, 孙凡. 基于YOLOv3的自然环境下茶叶嫩芽检测目标方法研究[J]. 电脑知识技术, 2021, 17(3): 14-16. DOI:10.14004/j.cnki.ckt.2021.0106 SHI Y Y, LI X R, SUN F. Research on target detection method of tea bud in natural environment based on YOLOv3[J]. Computer Knowledge Technology, 2021, 17(3): 14-16. DOI:10.14004/j.cnki.ckt.2021.0106 |

| [22] |

王子钰, 赵怡巍, 刘振宇. 基于SSD算法的茶叶嫩芽检测研究[J]. 微处理机, 2020, 41(4): 42-48. DOI:10.3969/j.issn.1002-2279.2020.04.011 WANG Z Y, ZHAO Y W, LIU Z Y. Research on tea bud detection based on SSD algorithm[J]. Microprocessor, 2020, 41(4): 42-48. DOI:10.3969/j.issn.1002-2279.2020.04.011 |

| [23] |

陈浩, 任奕林, 欧阳家乐, 陈佃贞, 王浩杰, 徐洋. 大田经济作物性状研究中的图像分割技术应用[J]. 广东农业科学, 2021, 48(11): 153-163. DOI:10.16768/j.issn.1004-874X.2021.11.019 CHEN H, REN Y L, OUYANG J L, CHEN D Z, WANG H J, XU Y. Application of image segmentation technology in the study of field cash crop characters[J]. Guangdong Agricultural Sciences, 2021, 48(11): 153-163. DOI:10.16768/j.issn.1004-874X.2021.11.019 |

| [24] |

GE Z, LIU S, WANG F, LI Z M, SUN J. YOLOX: Exceeding YOLOX series in 2021//Computer Vision and Pattern Recognition(CVPR)[C]. 2021. DOI: 10.48550/arXiv.2107.08430.

|

| [25] |

HU J, SHEN L, ALBANIE S, SUN G, WU E. Squeeze-andexcitation Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. DOI:10.48550/arXiv.1709.01507 |

| [26] |

BODLA N, SINGH B, CHELLAPPA R, DAVIS L S. Soft-NMSimproving object detection with one line of code//Computer Vision and Pattern Recognition(CVPR)[C]. Hawaii, USA: 2017. DOI: 10.48550/arXiv.1704.04503.

|

| [27] |

NEUBECK A, GOOL L J V. Efficient non-maximum suppression//18th International Conference on Pattern Recognition, Hong Kong, China[C]. Hong Kong, China: IEEE, 2006.

|

(责任编辑 邹移光)

2022, Vol. 49

2022, Vol. 49