文章信息

基金项目

- 广东省现代农业产业园项目(GDSCYY2022-046);深圳市科技计划项目(CJGJZD20210408092401004)

通讯作者

- 王宏乐(1984—),女,博士,高级工程师,研究方向为植物病理学和数字农业,E-mail: teajam@163.com.

文章历史

- 收稿日期:2023-05-17

2. 深圳市丰农数智农业科技有限公司,广东 深圳 518000

2. Shenzhen SenseAgro Technology Co., Ltd, Shenzhen 518000, China

【研究意义】水稻是我国乃至世界上最重要的粮食作物。科学、高效而准确地预测水稻产量,不但能为产量预估、收获、烘干和仓储物流提供及时、准确的农情信息,对于粮食的供需平衡、农业政策的制定等也具有重要意义[1-3]。目前,大面积的水稻估产主要采取卫星遥感估产的方法,如定量遥感反演与产量形成过程模型相耦合的方法、基于实测的水稻冠层反射光谱的多生育期复合估产模型等方法[4-5],但其在普适性、精准性和高效性等方面仍有待进一步优化和完善,获得更准确、及时的产量估算仍依赖于田间人工测产调查。特定品种的稻穗数量与水稻产量密切相关,准确获得田间单位面积水稻穗数是水稻产量准确预估的重要前提和基础[2-3, 6]。然而,田间单位面积水稻穗数的调查是人工测产调查过程中最费时费力的环节,同时,调查者的主、客观因素都极易影响调查结果的准确性[2-4]。因此,建立水稻产量快速调查的方法,对解放劳动力,提高测产工作效率和精度等具有重要意义。

【前人研究进展】目前水稻稻穗识别的主要技术为图像分割和目标检测。Xiong等[7]提出Panicle-SEG算法,实现了对不同品种及生育期大田稻穗的分割,准确率达到70%~80%。在此基础上,宋余庆等[6]基于DBSE-Net的大田稻穗图像分割,进一步提高了识别精度;Tanaka等8报道了基于水稻RGB图像的分割模型,可对多品种不同角度采集的稻穗进行精准识别及产量估算,经多地验证后,具有广泛的适应性和准确度。然而图像分割模型训练复杂,计算相对耗时,受图像背景影响大[3]。目标检测技术已运用于多个农业场景中,如麦穗检测。David等[9-10]报道并优化了小麦麦穗的识别算法,建立了全球麦穗检测数据集(Global Wheat Head Detection, GWHD)。此后,国内外大量学者对小麦穗数检测模型做出优化与改进,并开发出田间麦穗快速识别与计算的方法,包括基于无人机的麦穗图片的精准计数方法研发、小麦麦穗检测算法优化、小麦单位面积的实时在线检测方法的实现等[9-13]。与小麦相比,水稻不同品种间的穗形差异大,稻穗由于自重下垂,高种植密度下叶片与稻穗贴合更紧密,叶片对稻穗的局部遮挡使稻穗特征中混入叶片噪声,严重影响稻穗识别准确率和计数精度。姜海燕等[14]设计了一种基于生成特征金字塔的稻穗检测(Generative Feature Pyramid for Panicle Detection, GFP-PD)方法,对稻穗的识别准确率达90%以上。Sun等[3]使用改进的Y0L0v4对弯曲稻穗检测,解决了籼稻品种杂交稻的精准检测问题,在齐穗后7 d内能获得较高准确率。

【本研究切入点】粳稻和籼稻为我国主要的两大类水稻种植品种,品种的多样性和复杂性导致稻穗形状、颜色、姿态等存在一定差异,影响图像识别精准性。基于水稻稻穗的目标检测算法,虽已有一些研究报道,但缺乏其对不同品种稻穗估测的系统性研究,而在水稻稻穗深度学习训练数据集对深度学习模型的影响方面,更是缺乏相关报道。YOLO(You Only Look Once)是一种目前应用广泛的目标检测模型,可很好地平衡检测速度和检测精度,且拥有较好的小目标检测能力。其中YOLOv5凭借其较快的检测速度及良好的检测精度得到研究人员的青睐[11-13, 15]。根据宽度和深度的设置,YOLOv5分为YOLOv5s、YOLOv5m、YOLOv5l、YOLOv5x。其中YOLOv5l兼具较高的运算速度及不错的平均精度[11, 16]。Wang等[17]报道指出,新的网络结构YOLOv7,其整体准确度和速度均优于YOLOv5。目前已应用于安全头盔、交通标识等领域的目标检测,并取得不错的效果[18-19]。无人机具有快速、低成本、灵活获取高分辨率图像及农情信息的特点,尤其适合复杂农田环境的信息采集作业[1-2, 4-5, 12, 20]。本研究拟采用粳稻和籼稻主栽品种,研究无人机照片数据深度学习数穗测产技术对粳稻和籼稻的识别效果,尝试建立高效、可靠的稻穗快速检测计数技术。【拟解决的关键问题】本研究将重点解决无人机照片的数据清洗、稻穗标注、数据集构建和PyTorch深度学习建模训练方法,以期获得科学、高效和多品种适用性的数穗技术。

1 材料与方法 1.1 数据采集及稻穗田间调查水稻籼稻稻穗图片的采集和产量调查时间为2021年10月13日,地点为广东省广州市从化区生态优质丝苗米产业园,种植品种为美巴香占,随机选择11个调查点。水稻粳稻采集时间和产量调查时间为2022年11月5日,地点为广东省清远市飞来峡水稻种植基地实验田,种植品种为南粳46,随机选择9个为调查点。

图像采集时间为水稻齐穗期到灌浆期(图 1),稻穗穗形直立或略弯曲、不松散和不交缠。稻穗数据集的采集设备为大疆精灵4RTK无人机,云台拍摄角度为-85°~-90°之间,相机视角(Field of view,FOV)为84°,总像素为2 048万,分辨率为4 864×3 648。无人机图像于晴天10: 00— 14: 00采集,拍摄高度为距离水稻冠层1.7~1.8 m,拍摄图片的覆盖面积约为4 m2。每个调查点面积约为4 m2,圈出范围后在其正上方使用无人机采集图像,随后进行人工调查,人工调查方法参考Tanaka[6]。

|

| 图 1 水稻稻穗图片样例 Fig. 1 Sample of rice panicles images |

1.2 特征标注及处理

为降低重复图片数量以及非靶标图片对模型训练的干扰,采用人工筛选的方法对所采集图像进行数据清洗。清洗后的数据使用Labelimg软件[21]对目标稻穗分别进行水平框的框选,当图像边缘显示的谷粒面积≥ 30%以上时进行标定,否则不标定。水平框标注采用x、y、w、h表示,其中,x、y为目标框的中心坐标,w、h分别为沿X和Y轴的边界框的长度。

分别建立包含90张粳稻和籼稻标注图片的水稻稻穗数据集,其中包含粳稻样本28 728个、籼稻样本21 608个。依据两种水稻的不同特征,将数据集重新分组(表 1)。在目标检测算法中,重叠率(intersection of union,IoU)是在特定数据集中检测相应物体准确度的标准[18-24]。平均精度(mean Average Precision, mAP)为目标检测常用的判定指标,一般使用mAP@IoU的方式表示[11-16, 21]。分别从粳稻和籼稻的数据集中随机抽取10张作为独立测试集和验证集,其中测试集用于mAP的计算[22]。将图片尺寸调整到1 024×1 024后再进行训练与测试。

1.3 模型训练

水稻稻穗检测使用YOLOv5l和YOLOv7的网络体系结构。YOLOv5l参照李志军等[25]方法进行, YOLOv7模型训练参照Wang等[17]方法进行,模型的深度和宽度均设为1, 将前景和背景IoU阈值设为0.3。本研究基于PyTorch深度学习框架进行模型改进和算法训练。计算机配有NVIDIA V100的图形处理器(GPU),搭载Intel(R)Xeon(R)Gold 5218 CPU@ 2.30GHz,内存为128 GB。实验环境为Ubuntu 18.04 LTS 64位系统、Cuda11.3、Cudnn8.1.0、Pytorch1.7.1、Python3.7。模型训练的批处理大小为64,输入图像且统一为640×640分辨率。

1.4 模型验证及数据分析使用建立的模型对调查点采集的图像进行水稻稻穗数量预测,将预测结果与实际调查结果进行相关性比较分析,使用相关系数疋预测结果的准确性[1-2]。均方根误差(Root Mean Square Error,)—般用于反映测量值与真实值之间的偏差,平均绝对百分比误差(Mean Absolute Percentage Error,)可以反映预测值与真实值之间的相对距离[1, 8]。本研究使用R2、RMSE和MAPE对模型预测值与真实值进行验证和评价。

2 结果与分析 2.1 稻穗预测模型对水稻稻穗检测精度验证用相同的测试集对使用不同数据集训练得到的模型进行测试(表 1)。将模型对测试集的检测结果与真实值进行分析比较,计算得出每个锚框的IoU值。使用获得的IoU值制作箱型图(图 2),结果表明,在对粳稻测试集的检测中,模型1组所获得的IoU值的中位数最高,Y0L0v7模型为0.6733、YOLOv5模型为0.6455;其次为模型3组,Y0L0v7模型为0.6499、Y0L0v5模型为0.6230;模型2组所获得IoU值的中位数最低,Y0L0v7模型为0.4732、Y0L0v5模型为0.3794。在对籼稻测试集的检测中,模型2组所获得IoU值的中位数最高,YOLOv7模型为0.6494、YOLOv5模型为0.5403;其次为模型3组, YOLOv7模型为0.4862、YOLOv5模型为0.3933;模型1组获得IoU值的中位数最低,YOLOv7模型为0.4732、YOLOv5模型为0.2581(图 2)。基于此,为更合理地评价模型的识别精度,本研究除计算通用指标mAP@0.5外,同时考虑选择最低IoU的中位数0.2581,即计算mAP@0.25的值并参考作为评价标准。对于相同的数据,YOLOv7模型下IoU值的中位数普遍高于YOLOv5模型。

|

| 1-jing、1-xian的IoU值源自粳稻训练模型;2-jing、2-xian的IoU值源自籼稻训练模型;3-jing、3-xian的IoU值源自粳稻和籼稻训练的模型;箱中横线为中位数值 IoU values of 1-jing and 1-xian calculated by models detecting validation dataset of Oryza sativa sp. japonica, those of 2-jing and 2-xian calculated by models detecting validation dataset of Oryza sativa sp. indica, and those of 3-jing and 3-xian calculated by models detecting validation dataset of Oryza sativa sp. japonica and Oryza sativa sp. indica, respectively; The horizontal line in the box represents the median value 图 2 不同模型得到的重叠率分布情况 Fig. 2 Distribution of interscetion over union (IoU) from different models |

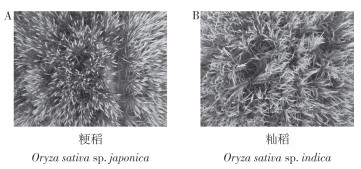

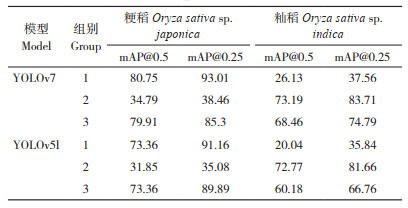

分别使用YOLOv7和YOLOv5l对3组数据进行训练,使用相同的测试集对模型进行测试和评价。结果表明,测试集对YOLOv7模型的测试结果普遍优于YOLOv5l(表 2、图 3、表 3)。仅使用粳稻数据训练得到的模型对粳稻有较好的识别精度,YOLOv7模型的mAP@0.5为80.75%、mAP@0.25为93.01%,优于YOLOv5l模型的mAP@0.5值73.36%、mAP@0.25值91.16%;但两种模型对籼稻的识别精度均不高,mAP@0.5及mAP@0.25在20%~40%。对籼稻识别最佳的模型为使用籼稻数据训练得到的模型,YOLOv7模型的mAP@0.5为73.19%、mAP@0.25为83.71%,优于YOLOv5l模型的mAP@0.5值72.77%、mAP@0.25值81.66%;但两种模型对粳稻识别精度不高,mAP@0.5及mAP@0.25在30%〜40%。使用粳稻和籼稻混合的数据训练得到的模型3组对粳稻和籼稻有一定的识别精度,基本能框出识别靶标,但低于仅使用粳稻数据训练得到的模型对粳稻的识别精度和仅使用籼稻数据训练得到的模型对籼稻的识别精度。

|

|

| 图 3 不同模型对水稻不同亚种稻穗的识别结果样例 Fig. 3 Detection results of rice panicles from different subspecies by different models |

结果表明,单一数据训练的模型对与其一致的靶标测试集的识别精度最高,对与其不一致的测试集测试精度最低,混合数据训练的模型对两种靶标均有一定的识别精度,但精度略低。所有模型的mAP@0.25值均明显大于mAP@0.5,重叠率对水稻稻穗的识别影响较大。

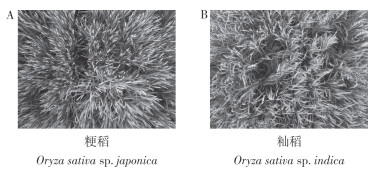

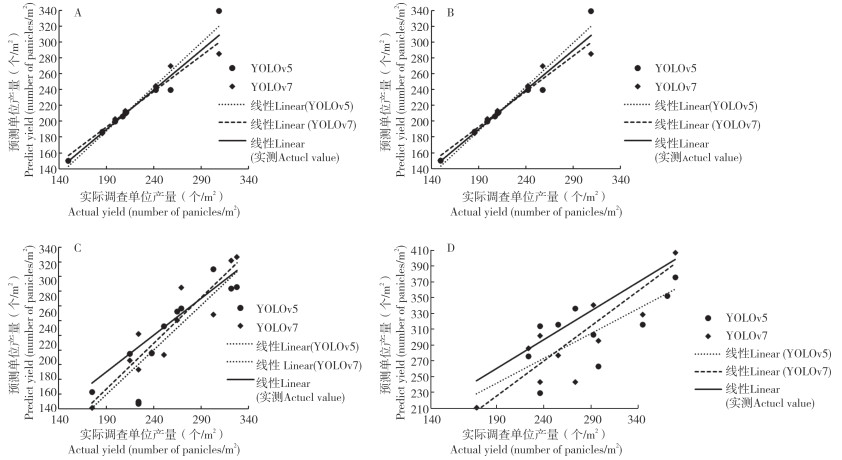

2.2 水稻稻穗田间调查及模型验证本研究设计了9个粳稻、13个籼稻的验证样本,对预测模型的预测结果进行验证和评价。结果(图 4)表明,仅使用粳稻数据训练得到的模型对粳稻有较好的识别精度,预测值与实测值显著相关。其中YOLOv7模型对粳稻预测精度最高,R2为0.9585、RMSE为9.17、MAPE为2.01%;其次为YOLOv5模型,R2为0.9522、RMSE为11.91、MAPE为2.15%。对籼稻识别最佳的模型为使用籼稻数据训练得到的,其中YOLOv7模型对籼稻预测精度最高,R2为0.8595、RMSE为24.22、MAPE为7.55%;其次为YOLOv5,R2为0.7737、RMSE为32.56、MAPE为7.83%。仅使用粳稻数据训练得到的模型对籼稻的识别效果不佳,仅使用籼稻数据训练得到的模型对粳稻识别效精度也偏低。但使用粳稻和籼稻混合的数据训练得到的对粳稻和籼稻均有一定的识别精度,低于仅使用粳稻数据训练得到的模型对粳稻的识别精度和仅使用籼稻数据训练得到的模型对籼稻的识别精度;其中YOLOv7模型对粳稻稻穗的识别效果较好,R2为0.9323、RMSE为13.17、MAPE为5.57%,对籼稻稻穗识别表现也较好,R2为0.7735、RMSE为37.73、MAPE为9.52%;YOLOv5模型对粳稻稻穗和籼稻的识别精度略低于YOLOv7,在对粳稻的识别中,R2为0.8919、RMSE为15.73、MAPE为6.01%;在对籼稻的识别中,R2为0.6201、RMSE为41.67、MAPE为10.94%。

|

| A、B预测值分别为模型1组、3组对水稻粳稻稻穗的预测值;C、D预测值分别为模型2组、3组对水稻籼稻稻穗的预测值 A, B: predict values of rice panicles numbers of Oryza sativa sp. japonica are predicted by model group 1 and model group 3, respectively; c, d: predict values of rice panicles numbers of Oryza sativa sp. Indica are predicted by model group 2 and model group 3, respectively 图 4 水稻稻穗预测值和实际值关系 Fig. 4 Relationships between predict values and actual values of rice panicles number |

3 讨论

在目标检测算法中,IoU是在特定数据集中检测相应物体准确度的标准,当IoU ≥ 0.5时,通常认为目标被预测正确。IoU阈值的设定对mAP值影响很大。而对于稻穗、麦穗等细小目标, 由于其形状细长,且为非规则图形,具有方向随意性,即使较小的角度变化也会导致IoU的迅速下降。黄硕等Hi]报道的YOLOv5检测模型对小麦麦穗的mAP@0.5也仅为0.467〜0.515。因此,诸多关于细小密集物体检测报道均会考量IoU低于0.5的情况[23-25]。本研究通过调查IoU的实际分布情况,将IoU的阈值设置为0.25°mAP值评价的是算法对图像识别的精度,在实际应用中,仍要考虑使用无人机采集稻穗图像的方法与真实情况之间的关系。因此,田间实际调查十分必要。通常使用模型的预测值与实际值建立回归方程,计算R2、RMSE以及MAPE等指标评价模型或方法的精度[1, 12, 32]。田间调查验证表明,所获得的最优模型的预测值,可较为准确地实现该场景下粳稻和籼稻的稻穗预测。其中,粳稻最优模型下预测值与调查值之间的R2值大于0.9、MAPE值小于5%,籼稻最优模型预测值与调查值之间的R2值大于0.8,MAPE值小于10%。本方法对籼稻的识别仍有优化空间,可通过增加或调整数据集结构来进行优化[22]。本研究所使用的算法也还有进一步优化的空间,如可考虑使用旋转框或高分辨率识别模型等方式,或通过引入Soft-NMS的判定机制,有可能进一步提升识别的精确度[3, 27-30]。

小麦麦穗具有顶端生长,形态特征大多直立或略弯曲,大多形态相似的特点,国内外已有诸多基于深度学习的小麦麦穗识别的报道[9-13]。David等[9-10]报道并优化了小麦麦穗的识别算法,建立全球麦穗检测数据集(Global Wheat Head Detection, GWHD)。然而水稻稻穗在成熟期后期单穗较重,易弯曲并交缠,较难通过图像数据进行稻穗计数[3, 6-7]。因而,有学者使用基于深度学习的图像分割技术来实现水稻稻穗的识别,但对于交缠的水稻,通过图像分割技术也较难直接计数,它们多是通过将分割的结果与田间实测穗数建立相关性关系,来实现田间穗数预测[6-7, 31]。本方法通过基于深度学习的目标检测方法来直接实现对田间水稻穗数的预测,实现路径更为简单、准确。但当水稻稻穗松散、下垂、交缠时,基于深度学习的图像识别检测算法,较难得到可靠的结果。本方法通过在水稻齐穗至灌浆期之间进行采集图像,来规避水稻稻穗松散交缠的情况发生,可以形成标准化的数据采集和穗数预测技术体系,但这也缩短了田间数据采集的时间窗口。在不同稻穗数据集上的表现结果表明,YOLOv7模型优于YOLOv5模型,与YOLOv7在其他领域的报道结果一致[17-19]。本试验建立的单位面积水稻穗数计算方法尚有不足,仍需进一步优化算法、引入面积计算机制,以进一步提高识别和计数准确率。

4 结论本研究初步建立了基于YOLOv7的无人机田间水稻单位面积穗数的快速调查方法,田间调查时间为从水稻齐穗期至灌浆期,所建立的预测模型和方法具有较高精度,可应用于实际田间测产工作。YOLOv7对稻穗的识别普遍优于YOLOv5,不同品种类型植株需要不同的稻穗计数测产模型和方法,本技术对粳稻的检测精度优于籼稻,对籼稻的检测算法需进一步优化。

| [1] |

田婷, 张青, 张海东, 何其全, 季方芳, 朱琳. 基于无人机遥感的水稻产量估测[J]. 中国稻米, 2022, 28(1): 67-71. DOI:10.3969/j.issn.1006-8082.2022.01.014 TIAN T, ZHANG Q, ZHANG H D, HE Q Q, JI F F, ZHU L. Development status, existing problems and countermeasures of early rice concentrated seedling cultivation in hunan province[J]. China Rice, 2022, 28(1): 67-71. DOI:10.3969/j.issn.1006-8082.2022.01.014 |

| [2] |

李昂, 王洋, 曹英丽, 于丰华, 许童羽, 肖文. 基于无人机高清数码影像的水稻产量估算[J]. 沈阳农业大学学报, 2017, 48(5): 629-635. DOI:10.3969/j.issn.1000-1700.2017.05.017 LI A, WANG Y, CAO Y L, YU F H, XU T Y, XIAO W. Rice yield estimation based on high-definition digital image of UAV[J]. Journal of Shenyang Agricultural University, 2017, 48(5): 629-635. DOI:10.3969/j.issn.1000-1700.2017.05.017 |

| [3] |

SUN B, ZHOU W, ZHU S, HUANG S, YU X, WU Z, LEI X, YIN D, XIA H, CHEN Y, DENG F, TAO Y, CHENG H, JIN X, REN W. Universal detection of curved rice panicles in complex environments using aerial images and improved YOLOv4 model[J]. Frontiers in Plant Science, 2022, 13. DOI:10.3389/fpls.2022.1021398 |

| [4] |

CEN H, WAN L, ZHU J, LI Y, LI X, ZHU Y, WENG H, WU W, YIN W, XU C, BAO Y, FENG L, SHOU J, HE Y. Dynamic monitoring of biomass of rice under different nitrogen treatments using a lightweight UAV with dual image-frame snapshot cameras[J]. Plant Methods, 2019, 15: 32. DOI:10.1186/s13007-019-0418-8 |

| [5] |

舒时富, 李艳大, 曹中盛, 孙滨峰, 叶春, 吴罗发, 朱艳, 丁艳锋, 何勇. 基于无人机图像的水稻地上部生物量估算[J]. 福建农业学报, 2022, 37(7): 824-832. DOI:10.19303/j.issn.1008-0384.2022.007.002 SHU S F, LI Y D, CAO Z S, SUN B F, YE C, WU L C, ZHU Y, DING Y F, HE Y. Estimation of aboveground rice biomass by unmanned aerial vehicle imaging[J]. Fujian Journal of Agricultural Sciences, 2022, 37(7): 824-832. DOI:10.19303/j.issn.1008-0384.2022.007.002 |

| [6] |

宋余庆, 杨东川, 徐立章, 刘哲. 基于DBSE-Net的大田稻穗图像分割[J]. 农业工程学报, 2022, 38(13): 202-209. DOI:10.11975/j.issn.1002-6819.2022.13.023 SONG Y Q, YANG D C, XU L Z, LIU Z. Segmenting field rice panicle images using DBSE-Net[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(13): 202-209. DOI:10.11975/j.issn.1002-6819.2022.13.023 |

| [7] |

XIONG X, DUAN L, LIU L, TU H, YANG P, WU D, CHEN G, XIONG L, YANG W, LIU Q. Panicle-SEG: A robust image segmentation method for rice panicles in the field based on deep learning and superpixel optimization[J]. Plant Methods, 2017, 13(1): 104. DOI:10.1186/s13007-017-0254-7 |

| [8] |

TANAKA Y, WATANABE T, KATSURA K, TSUJIMOTO Y, TAKAI T, TANAKA T S T, KAWAMURA K, SAITO H, HOMMA K, MAIROUA S, AHOUANTO K, IBRAHIM A, SENTHIKUMAI K, SEMWAL V K, MATUTE E, CORREDOR E, EI-NAMAKY R, MANIGBAS N L, QUILANG E J P, IWAHASHI Y, NAKAJIMA K, TAKEUCHI E, SAITO K. Deep learning-based estimation of rice yield using RGB image[J]. Research Square, 2021. DOI:10.21203/rs.3.rs-1026695/v1 |

| [9] |

DAVID E, SEROUART M, SMITH D, MADEC S, VELUMANI K, LIU S Y, WANG X, PINTO F, SHAFIEE S, TAHIR I S A, TSUJIMOTO H, NASUDA S, ZHENG B, KICHGESSNER N, AASEN H, HUND A, SADHEGI-TEHRAN P, NAGASAWA K, ISHIKAWA G, DANDRIFOSSE S, CARLIER A, DUMONT B, MERCATORIS B, EVERS B, KUROKI K, WANG H, ISHII M, BADHON M A, POZNIAK C, LEBAUER D S, LILLEMO M, POLAND J, CHAPMAN S, SOLAN B D, BARET F, STAVNESS I, GUO W. Global Wheat Head Dataset 2021:More diversity to improve the benchmarking of wheat head localization methods[J]. Plant Phenomics, 2021, 9846158. DOI:10.34133/2021/9846158 |

| [10] |

DAVID E, MADEC S, SADEGHI-TEHRAN P, AASEN H, ZHENG B, LIU S, KIRCHGESSNER N, ISHIKAWA G, NAGASAWA K, BADHON M A, POZNIAK C, SOLAN B D, HUND A, CHAPMAN S C, BARET F, STAVNESS I, GUO W. Global Wheat Head Detection (GWHD) dataset: a large and diverse dataset of high resolution RGB labelled images to develop and benchmark wheat head detection methods[J]. Plant Phenomics, 2020. DOI:10.34133/2020/3521852 |

| [11] |

黄硕, 周亚男, 王起帆, 张晗, 邱朝阳, 康凯, 罗斌. 改进YOLOv5测量田间小麦单位面积穗数[J]. 农业工程学报, 2022, 38(16): 235-242. DOI:10.11975/j.issn.1002-6819.2022.16.026 HUANG S, ZHOU Y N, WANG Q F, ZHANG H, QIU C Y, KANG K, LUO B. Measuring the number of wheat spikes per unit area in fields using an improved YOLOv5[J]. Transactions of the Chinese Society of Agricultural Engineering, 2022, 38(16): 235-242. DOI:10.11975/j.issn.1002-6819.2022.16.026 |

| [12] |

鲍文霞, 谢文杰, 胡根生, 杨先军, 苏彪彪. 基于TPH-YOLO的无人机图像麦穗计数方法[J]. 农业工程学报, 2023, 39(1): 155-161. DOI:10.11975/j.issn.1002-6819.202210020 BAO W X, XIE W J, HU G S, YANG X J, SU B B. Wheat ear counting method in UAV images based on TPH-YOLO[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(1): 155-161. DOI:10.11975/j.issn.1002-6819.202210020 |

| [13] |

臧贺藏, 赵晴, 周萌, 曹廷杰, 张杰, 李国强, 郑国清. 基于YOLOv5s模型的小麦品种(系)穗数检测[J]. 山东农业科学, 2022, 54(11): 150-157. DOI:10.14083/j.issn.1001-4942.2022.11.019 ZANG H C, ZHAO Q, ZHOU M, CAO T J, ZHANG J, LI G Q, ZHENG G Q. Spike number detection of wheat varieties (lines) based on YOLOv5s Model[J]. Shandong Agricultural Sciences, 2022, 54(11): 150-157. DOI:10.14083/j.issn.1001-4942.2022.11.019 |

| [14] |

姜海燕, 徐灿, 陈尧, 成永康. 基于田间图像的局部遮挡小尺寸稻穗检测和计数方法: J][J]. 农业机械学报, 2020, 51(9): 152-162. DOI:10.6041/j.issn.1000-1298.2020.09.018 JIANG H Y, XU C, CHEN Y, CHENG Y C. Detecting and counting method for small-sized and occluded rice panicles based on in-field images[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(9): 152-162. DOI:10.6041/j.issn.1000-1298.2020.09.018 |

| [15] |

郭瑞, 于翀宇, 贺红, 赵永健, 于慧, 冯献忠. 采用改进YOLOv4算法的大豆单株豆荚数检测方法[J]. 农业工程学报, 2021, 18(37): 179-187. DOI:10.11975/j.issn.1002-6819.2021.18.021 GUO R, YU C Y, HE H, ZHAO Y J, YU H, FENG X Z. Detection method of soybean pod number per plant using improved YOLOv4 algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 18(37): 179-187. DOI:10.11975/j.issn.1002-6819.2021.18.021 |

| [16] |

胡根生, 吴继甜, 鲍文霞, 曾伟辉. 基于改进YOLOv5网络的复杂背景图像中茶尺蠖检测[J]. 农业工程学报, 2021, 37(21): 191-198. DOI:10.11975/j.issn.1002-6819.2021.21.022 HUG S, WUJ T, BAO WX, ZENG WH. Detection of ectropis oblique in complex background images using improved YOLOv5[J]. Transactions of the Chinese society of agricultural engineering (transactions of the CSAE), 2021, 37(21): 191-198. DOI:10.11975/j.issn.1002-6819.2021.21.022 |

| [17] |

WANG C, BOCHKOVSKIY A, LIAO H M. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]. 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Vancouver, BC, Canada, 2023, 7464-7475. DOI: 10.1109/CVPR52729.2023.00721.

|

| [18] |

陈杨山, 张传庆, 赵曙光, 刘西钉, 王建强. 基于YOLOv7-Tiny的交通标识检测算法研究[J]. 计算机科学与应用, 2023, 4: 737-744. DOI:10.12677/CSA.2023.134072 CHEN Y S, ZHANG C Q, ZHAO S G, LIU X D, WANG J Q. Research on traffic sign detection algorithm based on YOLOv7-Tiny[J]. Computer Science and Application, 2023, 4: 737-744. DOI:10.12677/CSA.2023.134072 |

| [19] |

CHOURASIA S, BHOJANE R, HEDA L. Safety helmet detection: a comparative analysis using YOLOv4, YOLOv5, and YOLOv7[C]. 2023 International Conference for Advancement in Technology (ICONAT), Goa, India, 2023, 1-8. DOI: 10.1109/ICONAT57137.2023.10080723.

|

| [20] |

朱伟, 马立新, 张平, 刘德营. 基于GoogLeNet和无人机图像的水稻秧苗形态识别[J]. 华南农业大学学报, 2022, 43(3): 99-106. DOI:10.7671/j.issn.1001-411X.202107041 ZHU W, MA L X, ZHANG P, LIU D Y. Morphological recognition of rice seedlings based on GoogLeNet and UAV image[J]. Journal of South China Agricultural University, 2022, 43(3): 99-106. DOI:10.7671/j.issn.1001-411X.202107041 |

| [21] |

VARNIMA E K, RAMACHANDRAN C. Real-time gender identification from face images using you only look once (yolo)//2020 4th International Conference on Trends in Electronics and Informatics (ICOEI)[C]. IEEE, 2020.

|

| [22] |

PADILLA R, NETTO S L, SILVA E A B D. A survey on performance metrics for object-detection algorithms//2020 International Conference on Systems, Signals and Image Processing(IWSSIP)[C]. 2020. DOI: 10.1109/IWSSIP48289.2020.9145130.

|

| [23] |

AHMED F, TARLOW D, BATRA D. Optimizing expected intersection-over-union with candidate-constrained CRFs//IEEE International Conference on Computer Vision[C]. IEEE, 2016. DOI: 10.1109/ICCV.2015.215.

|

| [24] |

ETTEN A V. You only look twice: rapid multi-scale object detection in satellite imagery[J]. arXiv e-prints, 2018. DOI:10.48550/arXiv.1805.09512 |

| [25] |

李志军, 杨圣慧, 史德帅, 刘星星, 郑永军. 基于轻量化改进YOLOv5的苹果树产量测定方法[J]. 智慧农业, 2021, 3(2): 100-114. LI Z J, YANG S H, SHI D S, LIU X X, ZHENG Y J. Yield estimation method of apple tree based on improved lightweight YOLOv5[J]. Smart Agriculture, 2021, 3(2): 100-114. |

| [26] |

王宏乐, 王兴林, 李文波, 叶全洲, 林涌海, 谢辉, 邓烈. 深度学习训练数据分布对植物病害识别的影响研究[J]. 广东农业科学, 2022, 49(6): 100-107. DOI:10.16768/j.issn.1004-874X.2022.06.013 WANG H Y, WANG X L, LI W B, YE Q Z, LIN Y H, XIE H, DENG L. Impact of training data distribution on plant diseases recognition based on deep learning[J]. Guangdong Agricultural Sciences, 2022, 49(6): 100-107. DOI:10.16768/j.issn.1004-874X.2022.06.013 |

| [27] |

COURTRAI L, PHAM M, LEFEVRE S. Small object detection in remote sensing images based on super-resolution with auxiliary generative adversarial networks[J]. Remote Sensing, 2020, 12(19): 3152. DOI:10.3390/rs12193152 |

| [28] |

CHENG P, LIU W, ZHANG Y, MA H. LOCO: Local context based faster R-CNN for small traffic sign detection//Multimedia modeling[C]. International Conference on Multimedia Modeling, 2018: 329-341. DOI: 10.1007/978-3-319-73603-7_27.

|

| [29] |

MADEC S, JIN X, LU H, SOLAN H, LIU B, DUYME F, HERITIER E, BARET F. Ear density estimation from high resolution RGB imagery using deep learning technique[J]. Agricultural and Forest Meteorology, 2019, 264: 225-234. DOI:10.1016/j.agrformet.2018.10.013 |

| [30] |

王宏乐, 王兴林, 李文波, 邹阿配, 叶全洲, 刘大存. 一种基于解耦旋转锚框匹配策略的谷粒检测方法[J]. 广东农业科学, 2022, 49(12): 143-150. DOI:10.16768/j.issn.1004-874X.2022.12.016 WANG H Y, WANG X L, LI W B, ZOU A P, YE Q Z, LIU D C. A rice grain detection method based on rotation-decoupled detector for oriented object[J]. Guangdong Agricultural Sciences, 2022, 49(12): 143-150. DOI:10.16768/j.issn.1004-874X.2022.12.016 |

| [31] |

REZA M N, NA I S, BAEK S W, LEE K. Rice yield estimation based on K-means clustering with graph-cut segmentation using low-altitude UAV images[J]. Biosystems Engineering, 2019, 177: 109-121. DOI:10.1016/j.biosystemseng.2018.09.014 |

| [32] |

周元琦, 王敦亮, 陈晨, 李瑞, 李冬双, 刘涛, 孙成明, 仲晓春, 刘升平, 丁大伟. 基于无人机RGB图像颜色及纹理特征指数的小麦产量预测[J]. 扬州大学学报(农业与生命科学版), 2021, 42(3): 110-116. DOI:10.16872/j.cnki.1671-4652.2021.03.017 ZHOU Y Q, WANG D L, CHEN C, LI R, LI D S, LIU T, SUN C M, ZHONG X C, LIU S P, DING D W. Prediction of wheat yield based on color index and texture feature index of unmanned aerial vehicle RGB image[J]. Journal of Yangzhou University (Agricultural and Life Science Edition), 2021, 42(3): 110-116. DOI:10.16872/j.cnki.1671-4652.2021.03.017 |

(责任编辑 白雪娜)

2023, Vol. 50

2023, Vol. 50